|

Creating Virtual Worlds. Supercomputing in Astrophysics. El uso del telescopio por Galileo, ahora hace cuatrocientos años, hizo posible que fueran las observaciones astronómicas las que se utilizasen para validar o rechazar una hipótesis, en lugar de las prescripciones teológicas. Actualmente, las observaciones en los campos de la astrofísica y la cosmología no son muy diferentes, en espíritu cuando menos, a las rudimentarias de Galileo. En ambos casos nos hacemos preguntas, obtenemos datos observacionales y, finalmente, validamos o rechazamos una hipótesis inicial, es decir, aplicamos el método científico en estos ámbitos, con la diferencia de que nos encontramos ante ciencias observacionales y no experimentales. En contraste con las últimas, en las primeras no es posible diseñar experimentos para poner a prueba una hipótesis. En lugar de eso, hacemos observaciones adicionales, normalmente con mayor precisión, para distinguir las explicaciones correctas de las que no lo son. Una consecuencia inevitable en las ciencias observacionales es la multiplicidad de modelos. Cada vez que descubrimos un nuevo fenómeno astrofísico, aparecen un gran número de modelos teóricos que tratan de explicarlo. Las erupciones de rayos gamma son un ejemplo paradigmático: a finales de los años ochenta, el número de modelos propuestos era superior al centenar, muchos de los cuales eran excluyentes entre sí. Ante una situación como ésta nos sorprende una pregunta fundamental: ¿es posible minimizar los errores contenidos en los modelos teóricos en astrofísica y cosmología y amplificar el poder revelador de las observaciones? La respuesta es afirmativa. En este artículo explicaremos cómo la supercomputación puede considerarse como la analogía moderna y virtual del telescopio de Galileo. La supercomputación nos permite intentar convertir la naturaleza observacional de la astrofísica y la cosmología en otra de tipo experimental. La simulación numérica no sólo se ha convertido en uno de los tres pilares básicos del avance de la ciencia y la ingeniería junto a la observación/experimentación y teoría, sino que en algunos aspectos lidera la generación de conocimiento porque permite explorar aspectos que están fuera del alcance de cualquier otro método. Desde que el diario New York World utilizó el término supercomputación para hacer referencia a máquinas diseñadas para preparar el censo de los EE UU, los campos científicos y técnicos que se han beneficiado del cálculo de altas prestaciones han sido múltiples. Entre los grandes hitos de la supercomputación podemos encontrar (o encontraremos pronto) la secuenciación del genoma humano, el desarrollo de biocombustibles, la predicción meteorológica, el cálculo de riesgos y efectos de los desastres naturales, el estudio del nacimiento, evolución y muerte de las estrellas, o de la evolución del universo desde cerca del big bang hasta nuestros días. Los superordenadores son computadoras con prestaciones muy superiores a las habituales de los ordenadores personales de uso doméstico y se utilizan para simular o modelar procesos que demandan una gran cantidad de operaciones o la manipulación de un gran volumen de datos. Por ahora, los supercomputadores se componen de un gran número de procesadores capaces de operar en paralelo. Siguiendo la ley de Moore, que dice que el número de transistores en un chip se duplica cada 18 meses aproximadamente, los superordenadores nos han ofrecido un crecimiento exponencial de prestaciones. El crecimiento de la capacidad de cálculo en los últimos sesenta años ha sido tan importante que podemos hacer un paralelismo como el siguiente: los primeros ordenadores, como el Harvard Mark I, son a la construcción sencilla de cristales, muy pulidos por Galileo, como los más potentes superordenadores actuales (como el Roadrunner QS22) al Gran Telescopio de Canarias. |

«La supercomputación nos permite intentar convertir la naturaleza observacional de la astrofísica y la cosmología en otra de tipo experimental» |

|

|

||

|

■ ¿Por qué es necesaria la supercomputación? La mayor parte de las simulaciones numéricas están diseñadas para estudiar el comportamiento dinámico complejo contenido en el seno de un modelo teórico y, como objetivo final, reproducir observaciones. Asimismo, las simulaciones tienen una ventaja sobre las observaciones, ya que el nivel de detalle conseguido es mucho más grande, si se utilizan los algoritmos convenientes y la potencia de cálculo de los superordenadores. Uno de los hallazgos teóricos más importantes del siglo pasado fue entender que gran parte de los objetos astrofísicos, así como el medio interestelar e intergaláctico, y el mismo universo como un todo, pueden ser modelizados como fluidos en un grado de aproximación más que suficiente. Para resolver numéricamente problemas que involucran medios continuos hay que hacerlo mediante una colección finita de puntos, que deben ser representativos de las diferentes variables que definen el sistema (presión, temperatura, densidad, campo de velocidades…). Cada punto cambia su estado de acuerdo con las ecuaciones que gobiernen el modelo. Cuanto más grande sea el número de puntos que utilizamos para modelizar el sistema, más exacto será el modelo. En la práctica, son necesarios muchos y muchos puntos para resolver correctamente las escalas de interés del problema. Una estimación muy sencilla nos dice que, para realizar un cálculo típico en tres dimensiones, necesitaríamos meses de cálculo en un ordenador convencional. Claramente, nuestro ordenador de mesa no es suficiente, y más aún si, para realizar nuestro estudio, debemos recorrer el espacio de parámetros, de manera que tenemos que repetir los cálculos numerosas veces, dependiendo de la dimensión de este espacio que queremos explorar. Se hace, pues, imprescindible el uso de superordenadores y de muchos procesadores en paralelo. Un cálculo de meses en un ordenador se puede hacer en un día en un superordenador, mientras que el espacio de parámetros de interés se puede recorrer en pocas semanas. De manera genérica, podemos clasificar las simulaciones numéricas en dos grandes grupos: simulaciones numéricas directas y simulaciones numéricas paramétricas. Mientras que las primeras pretenden obtener resultados a partir de leyes básicas, primeros principios y un conjunto reducido de parámetros, las segundas ponen en juego modelos teóricos elaborados que, generalmente, dependen de muchos parámetros. Las primeras tienen un alto poder predictivo y dan respuestas claras a los problemas. No obstante, nuestra comprensión teórica del mundo físico es insuficiente para reducir a primeros principios todas las cuestiones. Además, las simulaciones directas necesitan grandes recursos computacionales para hacer predicciones macroscópicas porque se dirigen a escalas espaciales y temporales extremadamente pequeñas. Esto justifica el uso de las simulaciones paramétricas como metodología para obtener un conocimiento razonable. Tienen un poder predictivo más limitado y se utilizan generalmente para validar modelos teóricos existentes o para extenderlos al régimen no lineal, donde los cálculos analíticos son imposibles. Tanto la astrofísica como la cosmología modernas han alcanzado niveles de sofisticación y precisión tales que es imprescindible el uso de la supercomputación para construir modelos teóricos que expliquen los datos observacionales obtenidos gracias a los instrumentos más modernos. Sin pretender ser exhaustivos, analizaremos, a continuación, algunos de los escenarios astrofísicos y cosmológicos en los que las simulaciones numéricas se han convertido en un laboratorio virtual por excelencia para los científicos.

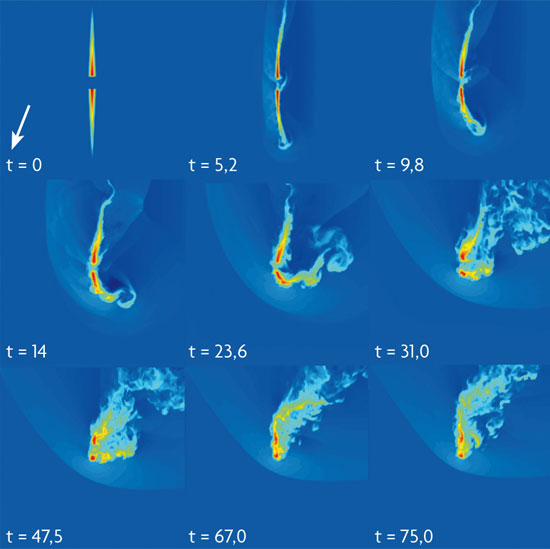

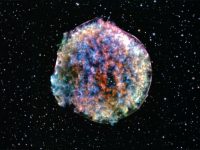

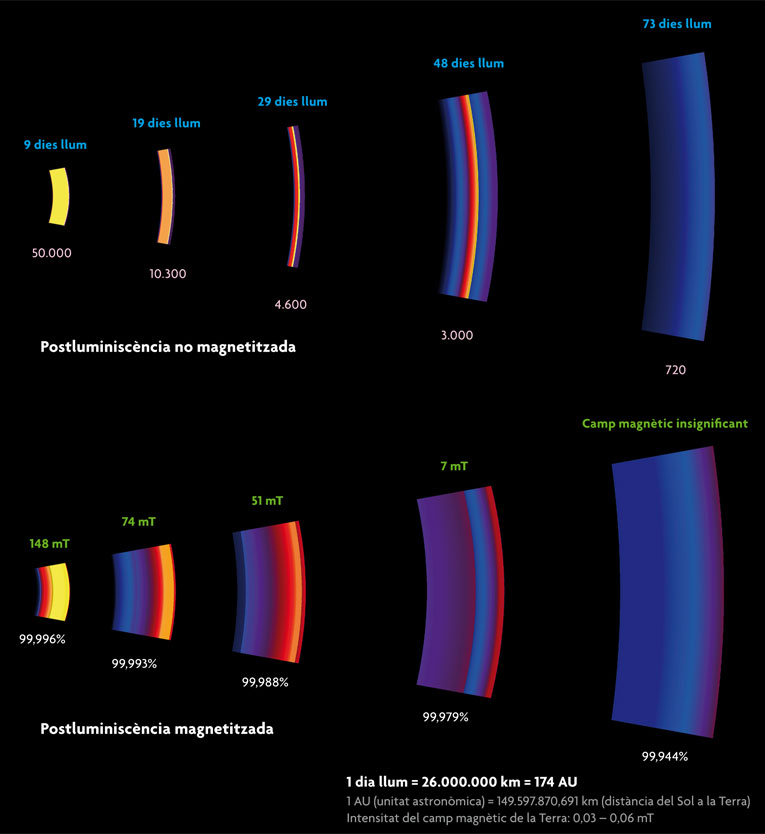

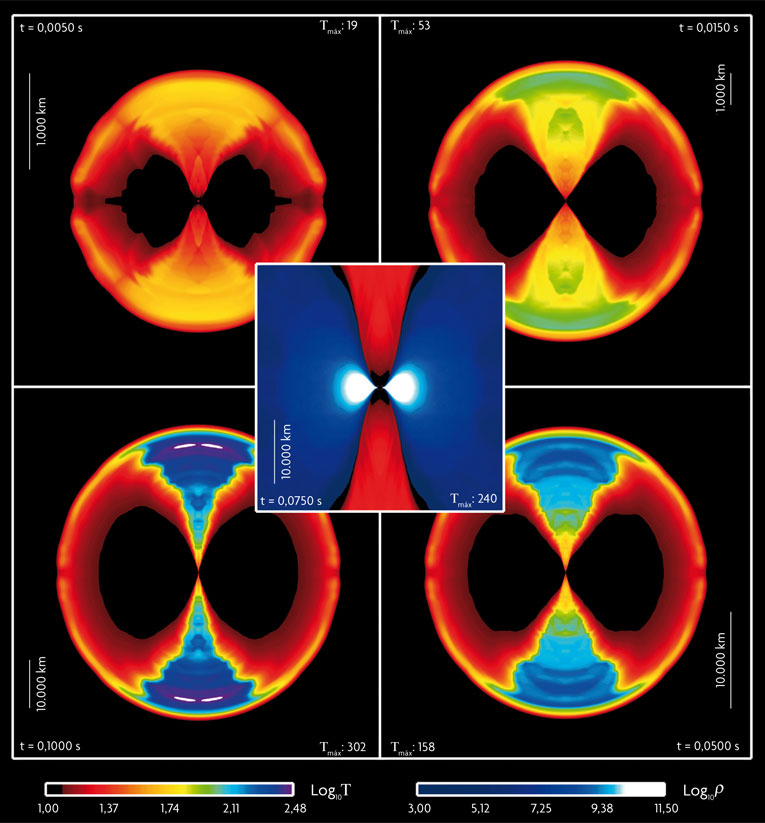

■ Supercomputación en astrofísica El extraordinario avance en la teoría moderna de la evolución estelar sería impensable sin resolver numéricamente las ecuaciones de estructura y evolución de las estrellas, incorporando los avances de la física nuclear. Eso nos permite, en la actualidad, no sólo entender las propiedades fundamentales de las estrellas, sino también predecir la evolución, en función de unos pocos parámetros. La consistencia, en líneas generales, entre las predicciones de la teoría y las observaciones permite disponer de un cuadro general coherente y preciso. Hay que destacar, en particular, las contribuciones que ha hecho la supercomputación para entender las fases terminales de las estrellas, como en el caso de las explosiones de supernova. Los cálculos más detallados incluyen el acoplamiento entre neutrinos y materia (necesario en las supernovas hidrodinámicas) o el estudio de la propagación de llamas en el seno de las enanas blancas (en las supernovas termonucleares). Las observaciones recientes de nuestro Sol con el satélite japonés HINODE han podido ser parcialmente explicadas en términos de complejos fenómenos magneticoconvectivos, gracias a sofisticadas simulaciones magnetohidrodinámicas. La presencia de flujos relativistas en el universo es un fenómeno común en los microcuásares, en las explosiones de rayos gamma y en las galaxias con actividad nuclear. Han sido las simulaciones numéricas realizadas con códigos (magneto-)hidrodinámicos relativistas las que han permitido entender aspectos morfológicos y dinámicos de estos objetos. Más aún, se han hecho predicciones, confirmadas por las observaciones, sobre detalles finos como son la estructura de choques en su seno, el origen (magneto-)hidrodinámico del fenómeno o, más recientemente, los mecanismos que operan en los lugares progenitores.

Este siglo verá el nacimiento y madurez de la astronomía de ondas gravitatorias, la nueva ventana al universo, complementaria a las que ya tenemos: la electromagnética, la de los neutrinos y la radiación cósmica. Las estrategias diseñadas para captar este tipo de señal extremadamente endeble y difícil de detectar exigen disponer de patrones precisos sobre lo que se espera detectar con antelación. Aunque la teoría analítica está muy desarrollada, estos patrones tan sólo pueden ser proporcionados por simulaciones numéricas. Los patrones sintéticos generados constituyen preciosos catálogos para los expertos en el análisis de señales en los detectores de ondas gravitatorias (por ejemplo, el futuro interferómetro espacial LISA). Los próximos años son prometedores en este aspecto y pondrán a prueba la capacidad predictiva de las simulaciones numéricas. Aunque no se pueden incluir como simulaciones restringidas al área de la astrofísica, la nueva generación de simulaciones directas en el campo de la física de plasmas nos ha permitido empezar a entender cómo se generan y comportan ciertas ondas de choque, conocidas como choques no colisionales, muy frecuentes en astrofísica. Estas simulaciones han predicho de manera precisa el espectro de energías de las partículas aceleradas en los choques, lo que es fundamental para estudiar la radiación de las fuentes astrofísicas. Más aún, estas simulaciones son importantes porque todas las estimaciones y resultados provienen de primeros principios y posiblemente representan la base de nuevos modelos de emisión radiactiva generales, aplicables a escenarios muy diferentes. |

© M. A. Aloy «Una estimación muy sencilla nos dice que, para realizar un cálculo típico en tres dimensiones, necesitaríamos meses de cálculo en un ordenador convencional»

«Tanto la astrofísica como la cosmología modernas han alcanzado niveles de sofisticación y precisión tales que es imprescindible el uso de la supercomputación para construir modelos teóricos» |

|

|

||

|

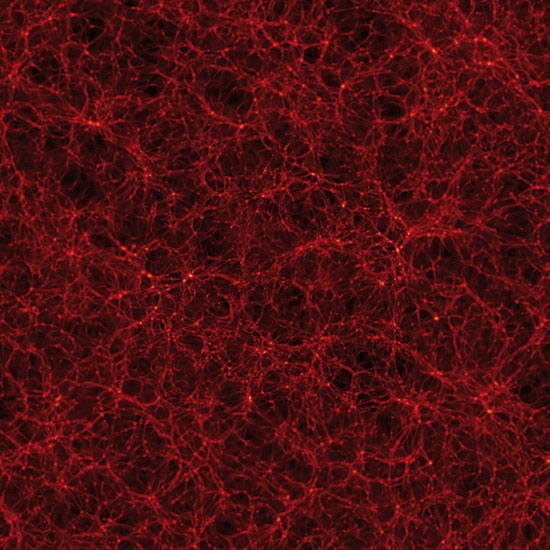

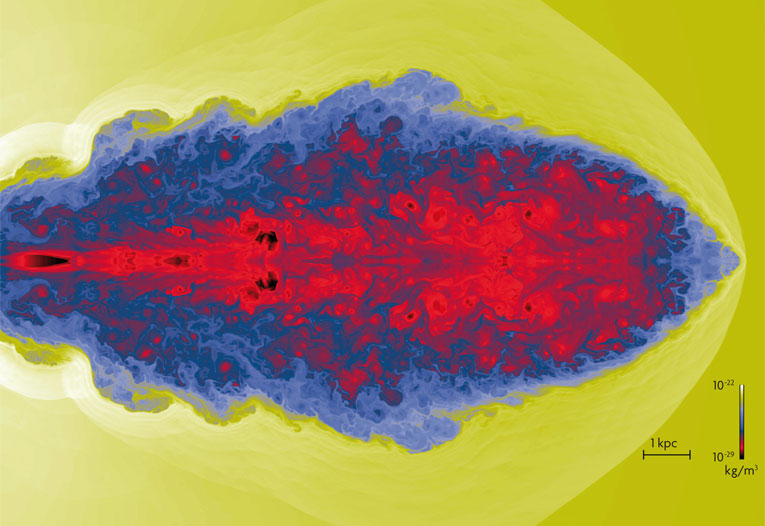

La cosmología es una de las ramas de la ciencia que mejor ejemplifica la importancia de la simulación numérica. Durante mucho tiempo, y hasta la llegada de lo que conocemos como cosmología de precisión, era una disciplina más próxima a la metafísica que a la física. A las dificultades intrínsecas del estudio de cualquier escenario físico complejo, se añadía la casi total falta de medios observacionales capaces de generar datos y la ausencia de un modelo teórico establecido. En esta coyuntura, las primeras simulaciones numéricas cosmológicas exploraron múltiples escenarios posibles y permitieron construir una descripción del universo como un todo. En algunos casos, las simulaciones lanzaron ideas, consideradas disparatadas en su momento y que, no obstante, son totalmente aceptadas en la actualidad, como, por ejemplo, la existencia de un componente de materia oscura absolutamente dominante en toda estructura cosmológica. El desarrollo de la supercomputación ha permitido que las simulaciones cosmológicas pioneras se hayan sofisticado, no solamente para tener acceso a un mayor poder de cálculo, sino también a un mayor detalle físico en los modelos y en los nuevos algoritmos. Hay que añadir el desarrollo de la instrumentación astronómica, que ha permitido abrir las puertas al universo más profundo y comparar los universos sintéticos de los superordenadores con el universo real que nos muestra la nueva generación de grandes instrumentos. Actualmente, el modelo cosmológico aceptado nos presenta un universo en el que sólo alrededor de un 4% de su contenido material corresponde a la materia ordinaria de la que está constituido el mundo que vemos. Por otro lado, se plantean grandes incógnitas, como la existencia de una enigmática energía oscura, o la naturaleza de una huidiza e indetectable materia oscura. Aunque son muchos los esfuerzos dirigidos a obtener información sobre estos temas mediante nuevos experimentos y observaciones, las simulaciones continúan teniendo un papel imprescindible en la cosmología moderna. |

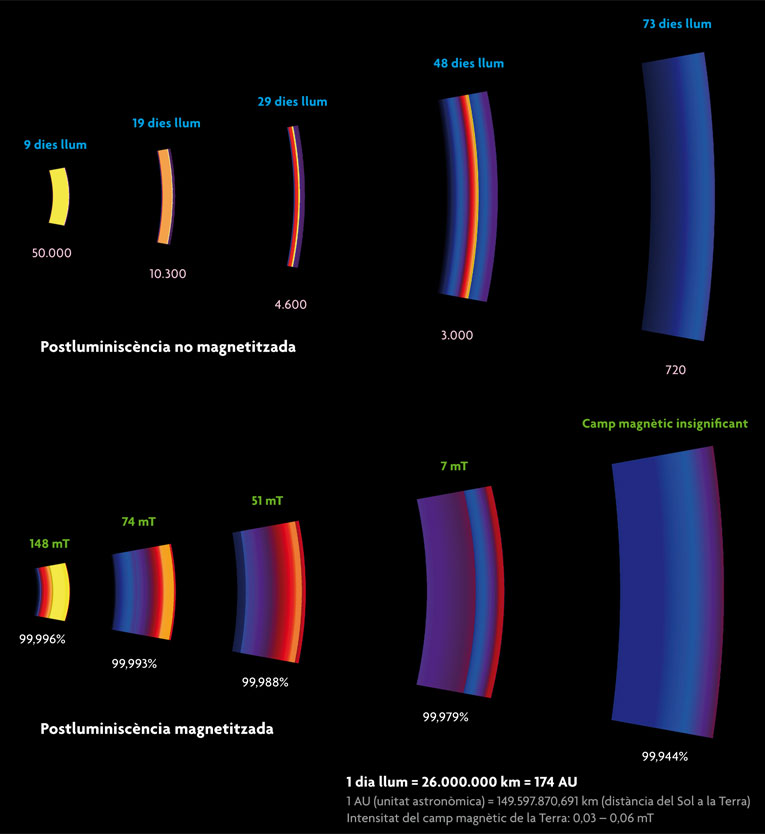

© M. A. Aloy Diversos instantes de las fases iniciales de la propagación de un chorro ultrarrelativista producido después de la fusión de dos estrellas de neutrones. Tal como se muestra en el panel central, después de la fusión de dos estrellas de neutrones se genera un disco grande de acreción con forma toroidal (la región más blanca y azulada del centro de la figura) que orbita alrededor de un agujero negro central. Un canal de muy baja densidad se forma alrededor del eje de rotación del agujero negro, donde se deposita tal cantidad de energía que se genera un flujo ultrarrelativista. Este chorro de plasma alcanza velocidades superiores al 99,995% de la velocidad de la luz (tonos rojizos en el panel central y pintado, según la escala de color situada en la parte inferior izquierda de la figura, referida al factor de Lorentz relativista). La ulterior propagación y la expansión lateral se muestran en los cuatro paneles marcados con tiempo de evolución, respectivamente, 0,005 s; 0,0150 s; 0,05 s y 0,1 s. En menos de una décima de segundo dos chorros, moviéndose en direcciones opuestas a lo largo del eje de rotación del sistema, alcanzan factores de Lorentz superiores a 300 (ver el panel inferior izquierdo) en escalas espaciales inferiores a los 10.000 km (desde el agujero negro central). Los datos necesarios para confeccionar esta figura exigieron del orden de 10.000 horas de cálculo con los superordenadores del centro de cálculo de la Sociedad Max-Planck en Garching (Alemania). |

|

|

||

|

■ Futuro La ley de Moore predice que la potencia computacional de los procesadores se verá limitada en los próximos años; por lo tanto, los supercomputadores continuarán basándose en arquitecturas multiprocesador con miles de estos elementos. Pese a ello, con las mejoras técnicas esperadas, las simulaciones podrían ser del orden de cien veces más precisas por dimensión espaciotemporal que en la actualidad. Por ejemplo, sería posible calcular la evolución de una estrella en tres dimensiones espaciales; o hacer simulaciones que permitan calcular la evolución de un fluido relativista acoplado al transporte de la radiación que se genere, lo que requiere cinco dimensiones (tres espaciales, una para la energía y el tiempo), con aplicaciones a los chorros extragalácticos o las explosiones de rayos gamma. Los avances aún no nos permitirán hacer las simulaciones directas a escala macroscópica, ni simulaciones paramétricas con capacidad de resolver las escalas más pequeñas (donde se desarrolla la turbulencia o los fenómenos no ideales como la reconexión del campo magnético). No obstante, esta mejora permitirá reducir la distancia entre los mundos macroscópico y microscópico en la astrofísica y la cosmología, y se podrán aplicar de manera sinérgica los resultados de las simulaciones directas en las simulaciones de gran escala mediante modelos subred. Es muy posible que las futuras aplicaciones computacionales nos permitan explorar nuevos métodos de simulación diferentes a los actuales. Hasta ahora, los problemas numéricos han sido tratados con códigos más o menos complejos que resuelven un conjunto de ecuaciones y se limitan a un rango de escalas dinámicas relativamente pequeño. Uno de los caminos más prometedores a explorar es el de los modelos multiescala y multifísica, donde cada escala utilice métodos numéricos y aproximaciones diferentes y el reto sea acoplar las piezas en el seno de un único código que capture de manera conveniente la interacción entre ellas. Evidentemente, si a medio plazo las tecnologías basadas en la computación cuántica alcanzan la madurez, muy posiblemente nuestras previsiones más optimistas se quedarán cortas y, quizá, será posible dar un salto cuantitativo muy superior en nuestra capacidad de cálculo y, por tanto, en nuestra comprensión del universo. BIBLIOGRAFÍA José María Ibáñez. Catedrático de Astronomía y Astrofísica, Universitat de València. |

© M. Perucho «Aunque son muchos los esfuerzos dirigidos a obtener información mediante nuevos experimentos y observaciones, las simulaciones continúan teniendo un papel imprescindible en la cosmología moderna» |

|