The Quest for Knowledge. Is the LHC safe?

Experimental Particle Physics using accelerators has currently reached an exciting moment, with the upcoming launch of the Large Hadron Collider (LHC) at the European Laboratory for Particle Physics (CERN). Nonetheless, public opinion has welcomed the news of this research tool with interest but at the same time with reservations.

La física experimental de partículas con aceleradores se encuentra actualmente en un momento extremadamente interesante ante la reciente puesta en marcha del Gran Acelerador de Hadrones (LHC) del Laboratorio Europeo para la Física de Partículas (CERN), cerca de Ginebra (Suiza), tras el intento fallido de 2008.

El 10 de septiembre del 2008, un equipo de físicos e ingenieros –liderado por el galés Lyn Evans– inyectó, por primera vez, haces de protones circulando con éxito a lo largo de todo el anillo del LHC. Tal acontecimiento tuvo un enorme impacto en los medios de comunicación, contribuyendo a despertar la percepción social y el interés por la física de altas energías.

El 19 de septiembre del 2008, durante las primeras pruebas de inyección de corrientes eléctricas elevadas en los dipolos del sector 3-4 del LHC (precisamente el último sector que quedaba por comprobar), una conexión defectuosa entre los cables superconductores pertenecientes a dos imanes adyacentes propició la formación de un arco eléctrico que perforó la cavidad que contiene el helio. La consiguiente fuga de ese (super)fluido a una temperatura de –271 grados Celsius produjo la degradación del vacío en las tuberías por las que circulan los dos haces de protones, así como el desplazamiento mecánico y daño de un número considerable de imanes. El CERN realizó un análisis muy detallado del incidente que hizo público mediante un comunicado de prensa.

«Sólo bajo ciertas hipótesis, las colisiones de protones en el LHC podrían dar lugar a la aparición de miniagujeros negros. Se trataría de un minúsculo agujero de masa tan escasa que se desintegraría casi instantáneamente»

Como resultado del gran impacto mediático de estos hechos, la opinión pública se pregunta: ¿por qué se ha tardado tanto en reparar el LHC? En primer lugar, para reemplazar y reparar los 53 imanes afectados del sector 3-4 ha sido necesario calentar dicho sector desde los –271 grados Celsius a temperatura ambiente, operación para la cual se requieren al menos dos meses. A continuación hay que subir los imanes desde 100 metros bajo tierra hasta la superficie, repararlos si es posible o substituirlos, bajarlos de nuevo, conectarlos, y finalmente volver a enfriar. Teniendo en cuenta que existen unas 10.000 conexiones del mismo tipo de la que falló a lo largo de todo el anillo del LHC, se han desarrollado sofisticadas técnicas de inspección y diagnóstico de conexiones. También se han instalado válvulas adicionales que liberan el exceso de presión y se ha reforzado el anclaje de los imanes en el suelo del túnel, y así minimizar los daños colaterales en el acelerador si a pesar de todo, un incidente parecido volviera a repetirse.

Los agujeros negros

El lamentable incidente con el helio nada tiene que ver con la supuesta peligrosidad de las colisiones del LHC relacionada con la posibilidad de la creación de agujeros negros que pudieran engullir nuestro planeta, y que ha provocado una reacción de miedo y en contra del LHC.

Para comprender adecuadamente qué es un agujero negro es conveniente introducir el concepto de velocidad de escape que caracteriza a cualquier astro del universo: un objeto lanzado verticalmente desde su superficie hacia el espacio exterior que superara dicha celeridad nunca retornaría al punto de partida. Naturalmente, la velocidad de escape depende crucialmente de la masa del astro en cuestión. En el caso de la Tierra resulta ser de unos 11 kilómetros por segundo. Es interesante notar que –afortunadamente para la vida– tal velocidad de escape es suficiente para conservar nuestra atmósfera pese a que haya moléculas gaseosas que, en ocasiones, pueden alcanzar velocidades extraordinariamente elevadas, tanto que pueden vencer la gravedad y perderse en el espacio exterior. La Luna, por el contrario, no ha sido capaz de retener ninguna atmósfera apreciable a lo largo de los años, ya que su masa es considerablemente inferior a la de la Tierra.

Imaginemos que pudiéramos comprimir suficiente materia en un espacio minúsculo, de modo que su gravedad fuera tan intensa como para que la velocidad de escape igualara a la velocidad de la luz. Entonces se delimitaría una región del espacio mediante el denominado «horizonte de sucesos», de la cual nada podría escapar, ni siquiera la luz; de ahí el nombre de agujero negro propuesto por John Wheeler en la década de 1960. Ciertamente, las densidades necesarias para conseguirlo impresionan: para que la Tierra se convirtiera en un agujero negro, se precisaría comprimir toda su masa hasta ¡ocupar el volumen de una pelota de tenis!

«Només sota certes hipòtesis, les col·lisions de protons a l’LHC podrien donar lloc a l’aparició de miniforats negres. Es tractaria d’un minúscul forat amb una massa tan escassa que es desintegraria quasi instantàniament»

En su formulación moderna, el concepto de agujero negro surge a partir de la teoría de la gravitación de Einstein como resultado de una deformación extrema del tejido espacio-temporal que al plegarse sobre sí mismo crearía una trampa para cualquier objeto. Curiosamente Einstein y otros grandes científicos rechazaron inicialmente la posible existencia real de tal singularidad, considerándola exclusivamente como una solución matemática sin interés más allá de lo académico. Sin embargo, hoy en día la comunidad científica admite no sólo la posibilidad de tales agujeros negros, sino que reivindica abiertamente la posibilidad de observarlos (aunque sea indirectamente) en el universo: en el centro de nuestra galaxia, la Vía Láctea, se supone que existe un agujero negro supermasivo.

Es conveniente destacar que la teoría de la gravedad de Einstein forma parte del cuerpo de doctrina conocida como física clásica, es decir, no tiene en consideración una de las facetas de la física más asombrosa y menos intuitiva para la mente humana: los efectos cuánticos. Hoy en día sabemos que la naturaleza es esencialmente cuántica, aun cuando los fenómenos cuánticos se manifiestan en todo su esplendor en el mundo subatómico. Incluso la propia existencia de los átomos se debe a las leyes de la física cuántica, pues, de otro modo, no podrían ser estables según el electromagnetismo clásico.

Hay fenómenos cuánticos tales como las fluctuaciones del vacío en aparente contradicción con las leyes de la física clásica: a partir de la «nada» se crea un par partícula/antipartícula (materia/antimateria) para aniquilarse tras un brevísimo lapso, restaurando, digámoslo así, la ortodoxia clásica. Tales procesos son denominados virtuales, y no reales, pues las partículas no son observables directamente. Advirtamos, sin embargo, las consecuencias prácticas: sin efectos cuánticos ningún dispositivo electrónico como la radio o la televisión, un ordenador o el iPod, podrían funcionar. Posiblemente nuestro cerebro tampoco.

El físico inglés Stephen Hawking se percató en los años setenta de que si tales fluctuaciones cuánticas del vacío tuvieran lugar cerca del horizonte de un agujero negro, una de las dos, partícula o antipartícula, podría ser absorbida por el agujero negro, mientras que la otra debería convertirse en partícula real, pues el horizonte de sucesos separaría a la pareja para siempre. Para un observador distante, el fenómeno se asemejaría a la emisión de una partícula real por parte del agujero negro, con la consecuente disminución de energía de éste.

«Si la teoría de las dimensiones adicionales fuera cierta, ya se habrían producido muchos miniagujeros negros durante los millones y millones de años de existencia de la Tierra»

La reiteración continuada de ese proceso a lo largo del tiempo (conocido como radiación de Hawking) ha de conducir a la «evaporación» (y a la larga a la eventual desaparición) del agujero negro. A partir de los cálculos teóricos se deduce que cuanto mayor sea la masa del agujero negro, más lento será el proceso de evaporación, ya que la temperatura del agujero negro es inversamente proporcional a su masa. Un agujero negro muy masivo necesitará un tiempo incluso mayor que la edad del universo para evaporarse totalmente (y por tanto no lo hará), mientras que uno más pequeño precisará de un tiempo menor. Este hecho resulta fundamental a la hora de valorar cualquier peligro asociado a las singularidades espacio-temporales que se puedan formar en el LHC, objeto de este artículo.

Así pues, volviendo al LHC, los protones colisionan provistos de una energía considerable en el mundo subatómico. Sin embargo, la cantidad equivalente de masa y, por ende, la densidad que se consigue en las colisiones es muchísimo menor que la requerida para formar un agujero negro de acuerdo con la teoría de la gravitación vigente. Por tanto no habría posibilidad alguna de que se forme un mini agujero negro en dicho colisionador.

No obstante, existen teorías más allá del modelo estándar que predicen que la gravitación aumenta enormemente su intensidad a distancias muy cortas (por debajo de la milésima de milímetro). Esto bien podría deberse a la existencia de dimensiones espaciales adicionales a las tres a las que estamos tan habituados. No podemos ni siquiera concebirlas porque nuestros sentidos, e incluso los instrumentos más precisos, no han sido capaces de percibirlas hasta ahora. Ahora bien, a pequeñas distancias la presencia de tales dimensiones significaría que el número de líneas de fuerza gravitatoria es realmente mayor que lo esperado por la conocida ley de la inversa del cuadrado de la distancia debida a Newton, implicando una gravedad (no convencional) mucho más intensa. Sólo bajo esa hipótesis, las colisiones de protones en el LHC podrían dar lugar a la aparición de miniagujeros negros. No se trataría obviamente de un agujero negro supermasivo que devora todo lo que encuentra a su alrededor, sino de un minúsculo agujero con una masa tan escasa que se desintegraría casi instantáneamente.

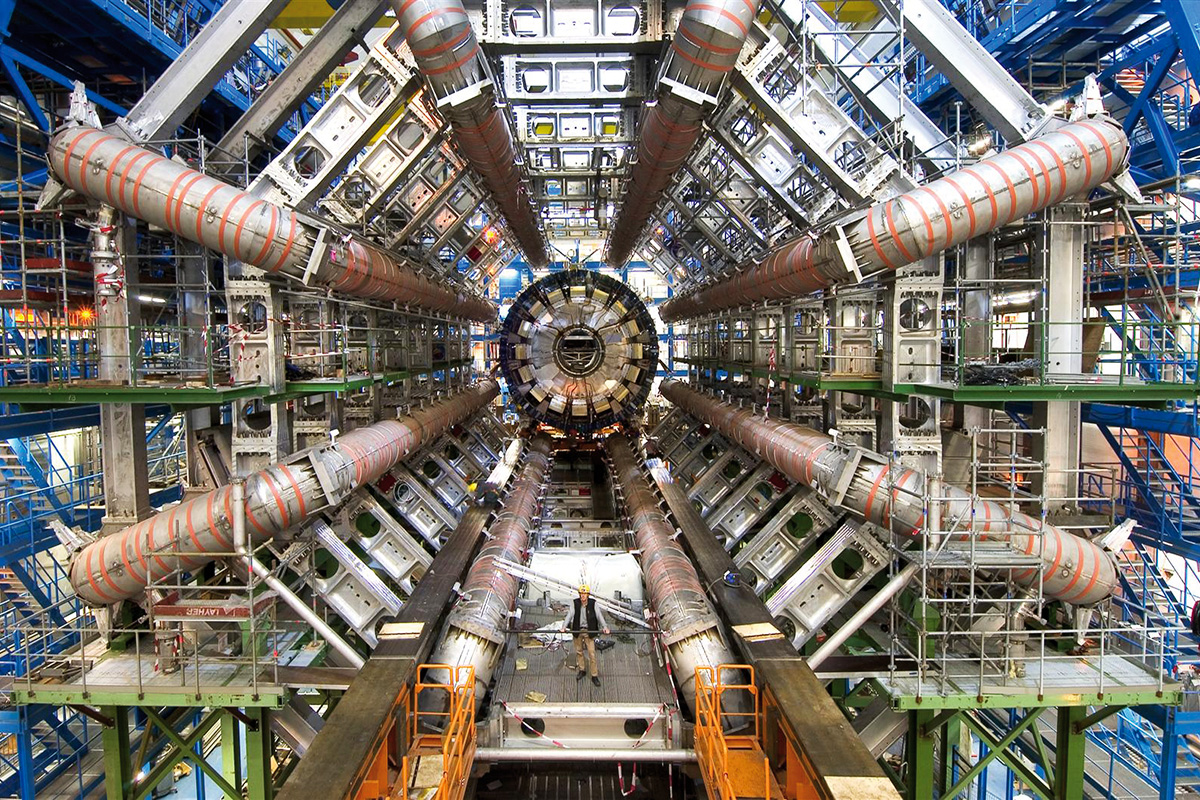

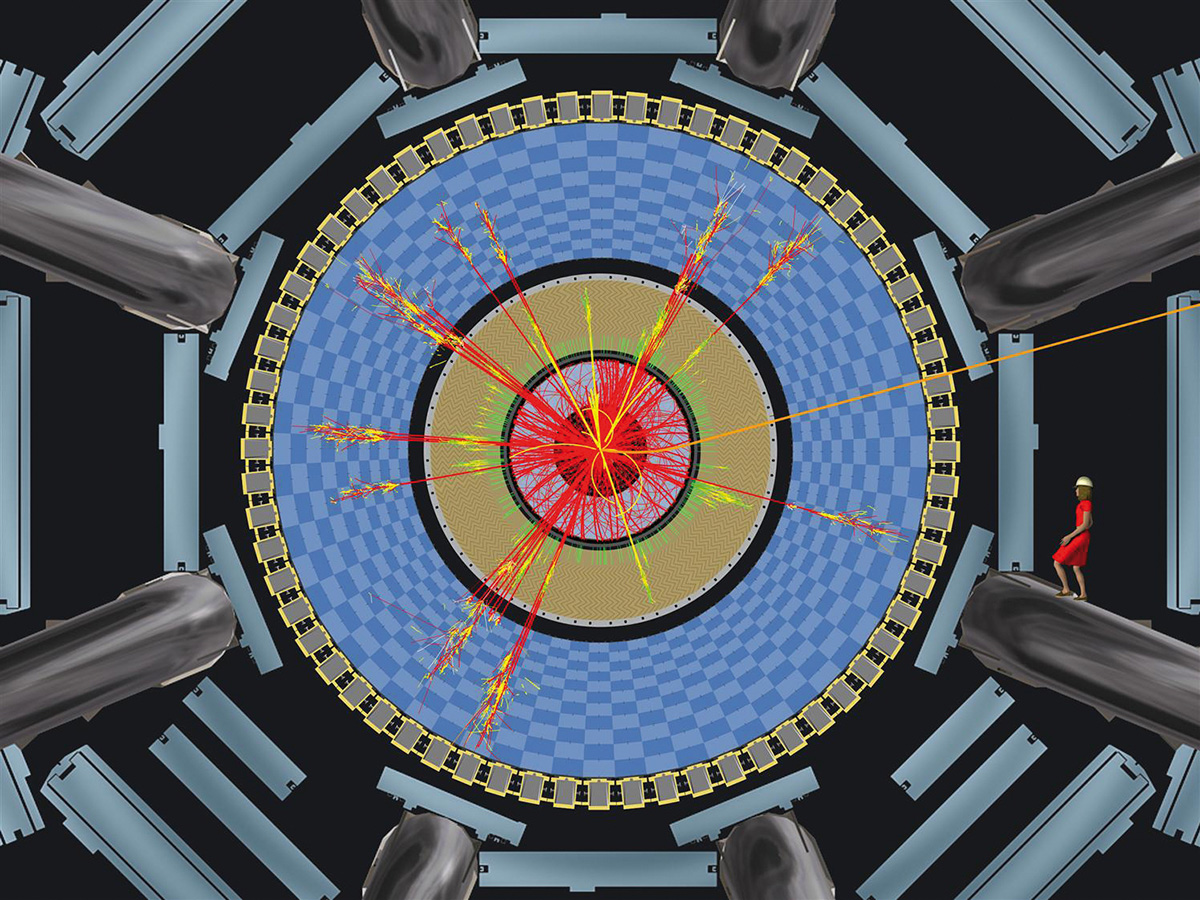

Existen ciertas teorías, todavía por demostrar experimentalmente, que plantean la posibilidad de producir miniagujeros negros. En la imagen de la derecha podemos ver la simulación de una colisión de haces de protones en la cual se ha producido un agujero negro microscópico. Este agujero negro se desintegraría rápidamente en muchas partículas, que serían detectadas y reconstruidas por el experimento ATLAS, uno de los detectores de partículas del LHC, que se puede ver en la imagen de la izquierda. / © CERN

eL miedo al LHC

Los científicos debemos ser siempre respetuosos con las desconfianzas o miedos que pueda producir la puesta en marcha de algún nuevo dispositivo o técnica innovadora. Sin duda es un derecho democrático expresar inquietudes, conocer los riesgos y exigir seguridad. En particular los «peligros» asociados a la formación de miniagujeros negros en el LHC han sido considerados seriamente por el CERN, pese a saber que la gravedad convencional no permitiría su formación en el LHC y que, más bien, se trata de una especulación basada en una teoría (sobre dimensiones extras) de la cual no existe evidencia alguna hoy por hoy. No obstante, el CERN ha abordado todas esas cuestiones en exhaustivos informes llevados a cabo por físicos independientes.

Es cierto, sin embargo, que unos pocos científicos sostienen que tales miniagujeros negros podrían no desintegrarse tan rápidamente como se cree y convertirse en una amenaza para el planeta entero. ¿Es posible pensar que quienes eso afirman tienen razón y que la gran mayoría de la comunidad científica está equivocada?

Pongamos un ejemplo tomado de otra rama de la ciencia. Existen personas, sin duda inteligentes, que ponen en duda la teoría darwinista de la evolución de las especies, a favor del creacionismo o diseño inteligente. Y sin embargo, ningún biólogo especialista, en su sano juicio, cuestiona que el hombre derive de seres más primitivos a lo largo de millones de años, aunque aún haya «eslabones perdidos» en la cadena evolutiva.

El hecho de que unos pocos científicos hayan planteado escenarios hipotéticos y poco plausibles de formación de miniagujeros negros peligrosos no puede llevar a la conclusión de que una teoría bien fundamentada sea falsa. De hecho, todos estos planteamientos han sido rebatidos por los científicos del CERN. El paradigma científico actual (gravitación y física cuántica) asegura que tales miniagujeros negros, si llegaran a formarse, no serían peligrosos.

Por otro lado, y como un motivo adicional de tranquilidad para aquéllos que puedan desconfiar de las predicciones teóricas, debemos resaltar que la propia naturaleza acelera partículas, frecuentemente con energías muy superiores al LHC. Se trata de los rayos cósmicos que proceden de muy diversas fuentes: nuestro Sol, nuestra galaxia, origen extragaláctico, púlsares, etc. Al llegar a las capas altas de la atmósfera de nuestro planeta, los rayos cósmicos producen los llamados «chaparrones de partículas» que llegan con facilidad hasta la superficie terrestre. Si la teoría de las dimensiones adicionales fuera cierta, ya se habrían producido muchos miniagujeros negros durante los millones y millones de años de la existencia de la Tierra. Un argumento semejante se aplica a cualquier objeto estelar observado mediante los telescopios, como el Sol, la Luna, los planetas del Sistema Solar, las enanas blancas, etc., y no se ha observado nunca la aparición del Armageddon en forma de agujero negro, pues, en caso contrario, la vida sobre la Tierra habría desaparecido hace tiempo y obviamente usted, amigo lector, no estaría leyendo estas líneas.

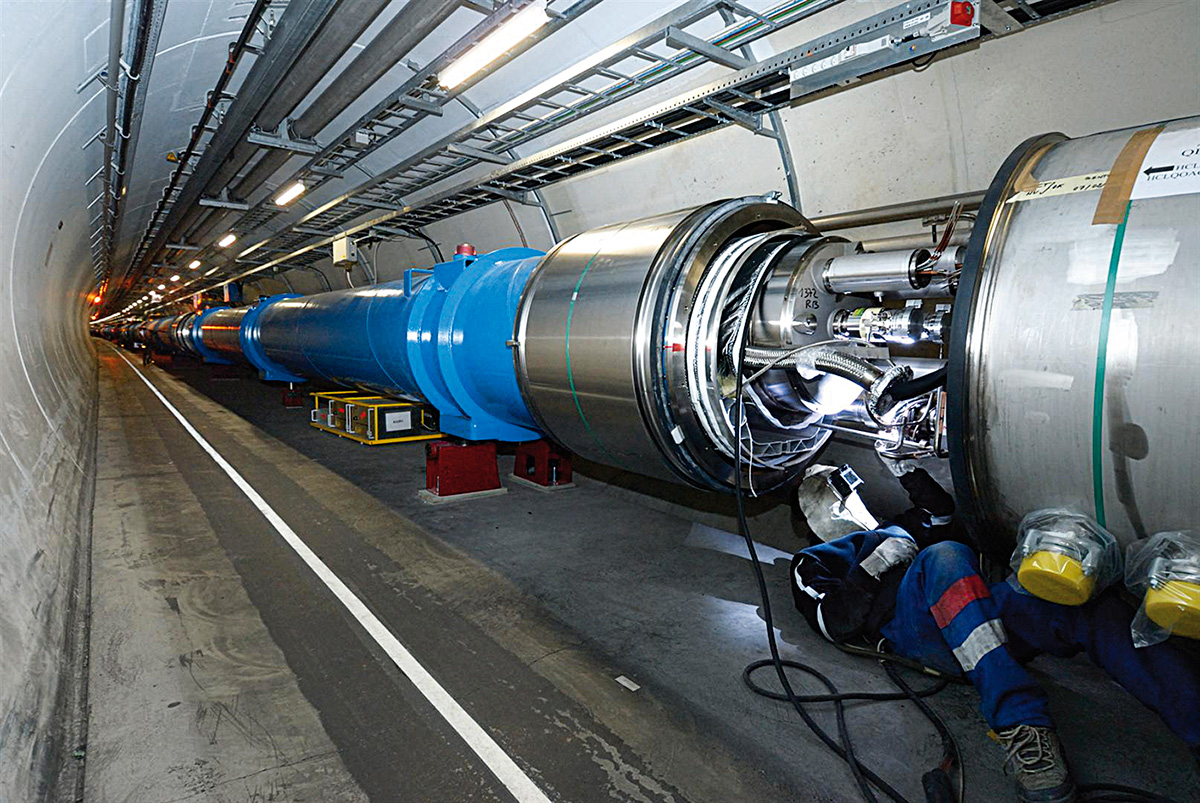

Detalle de las conexiones entre dos imanes del LHC. Un fallo en una conexión como ésta provocó la fuga de helio del 19 de septiembre de 2008 que ha obligado a realizar reparaciones durante más de un año antes de volver a ponerlo en marcha. / © CERN

los avances de los aceleradores de partículas

Una vez discutidas las posibles desconfianzas hacia el LHC, discutamos seguidamente las consecuencias positivas del acelerador para el avance de la ciencia y la tecnología. Desde sus orígenes, que se remontan a los años treinta, los aceleradores de partículas han sido concebidos, diseñados y utilizados para la investigación en física nuclear y física de altas energías. Actualmente se están utilizando, incluso, en campos tan diversos como la ciencia de materiales, la biología, la medicina o la arqueología. En el mundo hay más de 8.000 pequeños aceleradores de bajas energías (hasta unos pocos MeV por unidad de masa para iones ligeros) dedicados a implantación de iones, espectroscopia de masas, emisión de rayos X inducidos por protones (PIXE), etc. Hay unos 250 ciclotrones dedicados a la producción de isótopos, tanto para tratamientos tumorales como para usarlos en la tomografía por emisión de positrones (PET). En su mayoría, aceleran protones o deuterio hasta 30 MeV de energía. Hay también unos 10.000 aceleradores lineales de electrones (LINAC) que producen fotones de alta energía para radioterapia. Existen cerca de 30 aceleradores, entre instalaciones de investigación y hospitalarias, que funcionan por encima de 60 MeV para radioterapia con iones ligeros.

En el caso de los protones, las energías de tratamiento llegan hasta los 230 MeV y en el caso de los iones de carbono, hasta los 4800 MeV. Este tipo de tratamientos permite una precisa adaptación al tumor de la radiación al maximizar el control de éste y reducir a la vez el riesgo de efectos secundarios. Todos estos pequeños aceleradores han utilizado y siguen utilizando la I+D surgida de la construcción de grandes aceleradores y son un claro ejemplo de las aplicaciones de la física experimental.

No sólo los avances de la tecnología asociada al funcionamiento de los aceleradores de partículas están teniendo repercusiones positivas en el avance de la ciencia. Así, la explotación de los datos del LHC impone un continuo desafío para la computación al producir del orden de 15 petabytes de datos por año, equivalente a la información almacenada en una torre de CD de 20 km.

Ante este ingente volumen de datos y la necesidad de cálculo intensivo, se ha optado por utilizar un modelo de computación que incorpora los recientes avances en las tecnologías GRID, que permiten compartir recursos de cálculo y almacenamiento de datos en una red de institutos de investigación en todo el planeta. El GRID está, pues, convirtiéndose en un pilar fundamental en la consecución de objetivos importantísimos en otras áreas del conocimiento y de una intensa aplicación para la sociedad, tanto en meteorología, como en medicina, etc. Entre los logros de más repercusión social se encuentra la utilización de estas tecnologías para agilizar la selección de fármacos que combaten la malaria, una enfermedad que causa la muerte a un millón de personas al año. Estamos, por tanto, ante una aportación de gran calado procedente del contexto de la ciencia básica con repercusiones similares a las del advenimiento de la web a finales de los ochenta. Se puede decir en este sentido que el LHC es el instrumento más ambicioso para investigación básica y más complejo desde el punto de vista tecnológico jamás construido por el hombre.

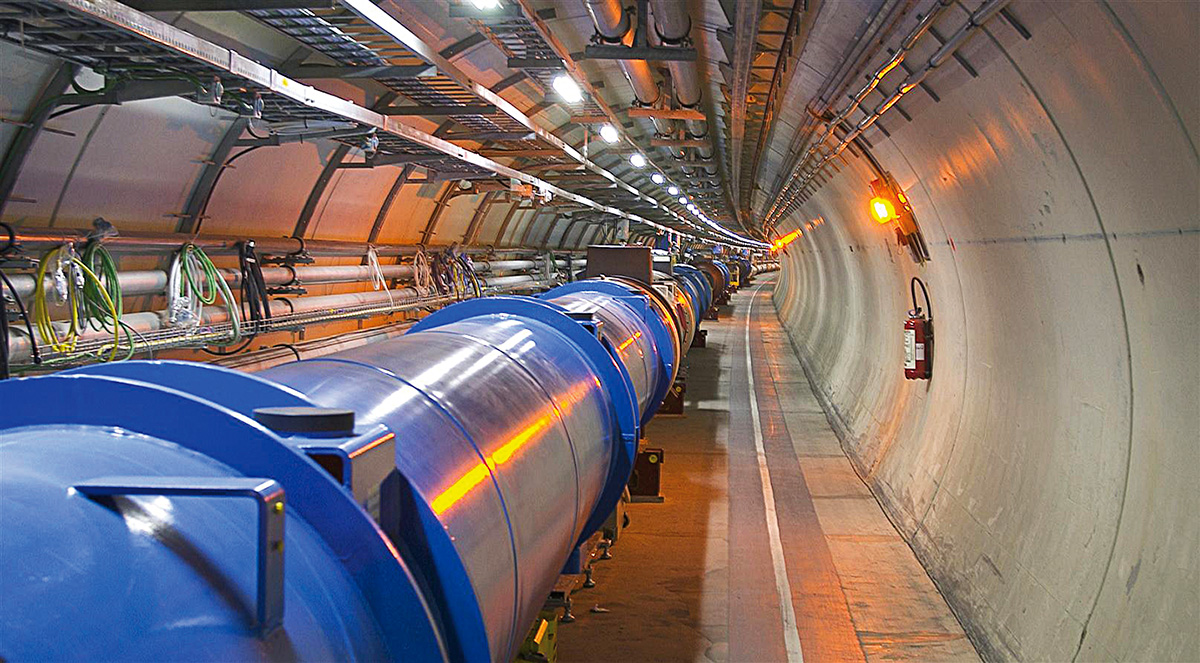

El LHC es hasta la fecha el instrumento más complejo destinado a la investigación básica. Los diferentes experimentos que se llevarán a cabo en él permitirán a los científicos conocer más sobre el funcionamiento y el origen del universo. En la imagen, un tramo del túnel del LHC. / © CERN

Qué es el LHC?

El Gran Colisionador de Hadrones (LHC) del CERN es un acelerador de partículas de tipo colisionador, donde dos haces de protones son acelerados hasta velocidades próximas a la velocidad de la luz mediante potentes imanes a lo largo de trayectorias circulares en sentidos opuestos. El LHC utiliza un túnel de 27 km de circunferencia. En las colisiones, la suma de la energía de los dos haces es la energía disponible para crear nuevas partículas (denominada en física energía del centro de masas) y alcanza nada menos que 14 teraelectronvoltios (TeV). Un TeV equivale a 1012 (un millón de millones) electronvoltios, siendo un electronvoltio la energía que adquiere un electrón en presencia de una diferencia de tensión de un voltio. En términos absolutos, un TeV es del orden de la energía asociada al movimiento de un mosquito, pero los imanes del LHC concentran esa energía en un espacio un millón de millones de veces más pequeño que el tamaño del insecto.

La teoría actual que describe las propiedades de las partículas elementales y sus interacciones se conoce como el Modelo Estándar. Sin embargo, esta teoría no explica el origen de la masa ni describe las interacciones fundamentales entre las partículas elementales de una manera unificada, ni los fenómenos constatados recientemente por observaciones en astrofísica y cosmología: la ausencia de antimateria en el universo y el hecho de que la materia visible solamente constituye el 4% del universo, mientras que el 96% restante es materia oscura (23%) y energía oscura (73%). En el LHC, los científicos esperan descubrir las partículas y los procesos que constituyen el lado oscuro del universo.

NOTAS 1. El comunicado se puede consultar en: <http://press.web.cern.ch/press/PressReleases/Releases2008/PR14.08E.html>. (Volver al texto) 2. <http://public.web.cern.ch/public/en/LHC/Safety-en.html>. (Volver al texto)