Redes sociales y compañía robótica

Tecnología, ética y ciencia-ficción

Las tecnologías de la información se han instalado en nuestra cotidianidad y vehiculan cada vez más las relaciones laborales y personales, cuando no las sustituyen. Esta creciente interacción con máquinas plantea una serie de cuestiones sobre las que no hay experiencia, y tampoco una predicción fiable para saber cómo influirán en la evolución de la sociedad. Eso ha propiciado la confluencia de tecnociencia y humanidades en un debate ético que empieza a dar frutos, no solo con el establecimiento de normativas y estándares, sino también con iniciativas educativas, tanto en docencia universitaria como de mejora profesional y formación de opinión pública. A menudo la ciencia ficción representa un papel especulativo destacado, que resalta los pros y contras de posibles escenarios futuros.

Palabras clave: redes sociales, robótica asistencial, ética, ciencia ficción, ciencias y humanidades.

Las redes y los robots se convierten en «sociales»

La invención de internet y la irrupción de los teléfonos móviles han propiciado la aparición de las redes sociales, un fenómeno nada fácil de prever hace tan solo un par de décadas. Como tampoco lo era que los robots saliesen del ámbito estrictamente laboral para dar paso a los llamados robots sociales, que cada vez veremos más en entornos cotidianos: cuidando a personas con discapacidades y personas mayores, haciendo de recepcionistas o dependientes en centros comerciales, como guías en ferias y museos, actuando como compañeros de juego de jóvenes y adultos, e, incluso, ejerciendo de niñeras y maestros de refuerzo.

«Las nuevas tecnologías informáticas y robóticas inciden en el círculo social y de relación entre las personas»

Las tecnologías informáticas y robóticas representan un paso más en la transformación social que empezó con la revolución agraria y continuó con la revolución industrial, pero introducen una diferencia cualitativa. Ya no se trata meramente de mecanizar trabajo pesados y repetitivos en el campo y en las fábricas, o de que los electrodomésticos liberen tiempo que las personas puedan utilizar de manera más creativa y placentera. La diferencia es que estas nuevas tecnologías inciden en el círculo social y de relación entre la personas, es decir, entran en la esfera de las emocione y de los sentimientos.

Esto hace aflorar una serie de cuestiones éticas que no tenía sentido plantear para otros tipos de máquinas. Por ejemplo, una persona enferma podría creerse que el robot que la cuida se preocupa realmente por su bienestar y delegarle todas las decisiones. O un niño podría pensar que su compañero robótico es un verdadero amigo. Un ordenador portátil de trabajo sabría cuándo y dónde ha sido más productivo el usuario y podría compartir esta información con otros dispositivos para optimizar su rendimiento o bien el consentimiento del usuario. Por no hablar de la capacidad de manipulación de los llamados influencers y de los posibles malos usos de la gran cantidad de información que compartimos en las redes sociales.

Oportunidades y peligros en las redes sociales

Un influenciador (en inglés, influencer) es aquella persona capaz de influir en el proceso de decisión de otra persona. Se puede influir sobre la gente para obtener poder y, viceversa, se puede utilizar el poder para influir. Internet ha representado un gran cambio en las pautas de persuasión, ya que ha multiplicado las posibilidades de influencia poniéndola al mismo tiempo al alcance de cualquier persona. Michael Wu, un experto en análisis de redes sociales, ha identificado seis factores que determinan la capacidad de influencia (Wu, 2012). Por una parte, aspectos genéricos como la credibilidad del influenciador y la audiencia que tiene, y, por otra, aspectos ligados al receptor de la influencia: la confianza que le merece el influenciador, la relevancia de la información, así como su oportunidad en el tiempo y el espacio (factores que en inglés se conocen como «the right person, information, time, and place»). Por lo que respecta a los dos primeros, no existen ni influenciadores universales ni medios de comunicación generales. Un influenciador lo es solo en su dominio de pericia y a través del canal adecuado. La oportunidad temporal del mensaje es decisiva, ya que está demostrado que solo existe una ventana de oro (golden window) en la que el destinatario está interesado en tomar una decisión y abierto a considerar varias opciones. Esta ventana se detecta por acciones que el usuario realiza, como añadirse a un grupo temático o bien hacer una pregunta en un foro. De hecho, la pretensión no es convertirse en un buen influenciador per se, sino tejer una red de influenciadores establecidos que haga llegar oportunamente cada mensaje a los destinatarios adecuados.

Los influencers se han convertido en poderosos creadores de opinión, a veces con consecuencias negativas como la propagación de noticias falsas y la introducción de sesgos en procesos electorales. ¿Es posible regular su capacidad de influencia sin atentar contra la libertad de expresión? A menudo nos sentimos manipulados por los anuncios personalizados con los que nos bombardean todo tipo de aplicaciones, pero les entregamos cándidamente nuestros perfiles. En especial los jóvenes, que demasiado a menudo no son conscientes de los posibles malos usos de la información que comparten en las redes, que puede ser utilizada para el acoso escolar, para chantajes e intimidaciones, o simplemente puede jugar en su contra a la hora de buscar trabajo. La mayoría de ataques informáticos y amenazas en las redes se hacen desde el anonimato y, evidentemente, tienen un alcance muy superior al que podría darse en el mundo físico.

Pero estos peligros no pueden enmascarar las inmensas posibilidades que ofrecen las redes. Por ejemplo, para el trabajo colaborativo. Pensemos en los bancos de tiempo, en los que profesionales diversos intercambian sus servicios, o el traductor de Google, que, tras realizar una traducción, pregunta al usuario si tiene sugerencias de mejora, las cuales incorporará a su estadística para ir perfeccionando traducciones semejantes futuras. También son destacables los juegos de impacto social como el célebre Evoke, que insta a jugadores de todo el mundo a resolver retos, especialmente de las comunidades de África. Se anima a los participantes a aprender sobre los países en desarrollo, a actuar sobre la base de este conocimiento y a utilizar la creatividad para imaginar un buen futuro para el planeta. A través de la narración de un cómic como línea argumental, los jugadores tienen que completar desafíos como la lucha contra el hambre en el mundo, el uso de energías renovables, la potenciación del papel de la mujer o diseñar un plan de acceso igualitario al agua potable. Para conseguir el objetivo, los jugadores pueden utilizar «superpoderes» como son la colaboración, la valentía, el ingenio y el emprendimiento. Otros juegos de este tipo son «A force more powerful» (“Una fuerza más poderosa”), en el que los jugadores han de inventarse estrategias de resistencia pacífica para superar situaciones de opresión en una comunidad, o «Participatory Chinatown» (“Chinatown participativa”), que pretende ayudar a los residentes de este distrito de Boston a mejorar el desarrollo futuro de su vecindad. Muchos de estos juegos permiten a los usuarios aprender sobre problemas sociales. Sin embargo, hasta ahora, son pocos los que han alcanzado resultados medibles en el mundo real.

¿Qué directrices hay que seguir para diseñar un juego que pueda conducir a un cambio social? Swain (2007) sugiere las siguientes: definir con precisión los resultados esperados, integrar expertos en la materia, asociarse con organizaciones afines, construir una comunidad sostenible, abordar problemas que no tengan unas reglas claras, mantener la integridad periodística, medir la transferencia de conocimientos, y conseguir que sean divertidos.

«Algunos temas abordados en las obras de Asimov, Dick o Bradbury han cobrado actualidad con el desarrollo de los robots sociales»

Sin embargo, la mayoría de videojuegos buscan solo el entretenimiento sin apelar al interés genuino de los jugadores para resolver problemas. Según datos de la Asociación de Software de Entretenimiento, un joven americano de 21 años ha pasado una media de 10.000 horas jugando a juegos de ordenador; eso equivale a cinco años de trabajo a razón de cuarenta horas por semana. No es extraño que surgiese la idea de sacar rendimiento a esta gran cantidad de horas que se invierten jugando. Luis von Ahn y Laura Dabbish fueron los primeros en diseñar juegos atractivos que, como subproducto, solucionaban problemas o generaban datos que permitían entrenar algoritmos de aprendizaje automático (Von Ahn y Dabbish, 2008). Un ejemplo es el juego ESP, que ha dado lugar al etiquetado de imágenes de Google. Al presentarles una imagen, los jugadores tienen que teclear los nombres de los objetos que ven lo más deprisa que puedan; las coincidencias de los jugadores determinan las mejores etiquetas y también los rankings con los que se asignan las recompensas. La velocidad media de etiquetado es de 233 etiquetas por hora y el tiempo de juego, 91 minutos. En el diseño del juego se han aplicado varias estrategias para motivar a los jugadores: límites de tiempo, niveles de pericia, listas de puntuaciones máximas por categoría, y aleatoriedad en las sucesiones de imágenes presentadas. También se han implementado mecanismos para asegurar la calidad del etiquetado resultante, así como para evitar fraudes (por ejemplo, que varios usuarios se pongan de acuerdo para obtener el máximo número de coincidencias sin ser fieles al contenido de las imágenes).

Este tipo de juegos, bautizados como juegos con propósito, han dado lugar a la ludificación, tan extendida hoy. En este ámbito surge la pregunta: ¿Es éticamente aceptable diseñar juegos o cualquier tecnología con el objetivo de crear adicción y sacar provecho?

Si tradicionalmente la evolución tecnológica ya iba a menudo por delante del análisis de sus implicaciones sociales, ahora que las innovaciones son constantes y se integran en un abrir y cerrar de ojos en la cotidianidad, podríamos decir que estamos asistiendo en tiempo real a un experimento de alcance mundial, sin estudio previo. Es difícil predecir, de manera fundamentada, la influencia que la hiperconectividad y la creciente interacción con máquinas tendrán en la evolución de la sociedad, de la economía y en la vida de las personas. Por ello, cuando se intenta establecer un debate ético, a menudo se recurre a la ciencia ficción. Si no se dispone de modelos cuidados que permitan hacer predicciones fiables, una opción razonable es imaginar diferentes escenarios futuros posibles y discutir los pros y los contras para formarnos un criterio bien argumentado.

Hay varias obras de ficción que tratan con acierto cuestiones de carácter afectivo, psicológico y social ligadas a la tecnología informática, y favorecen la discusión. Destacaría la serie Black Mirror, la película Her y la novela El ciclo de vida de los objetos de software, por mencionar algunas. Yo también he querido contribuir al debate con la novela Enxarxats (Torras, 2017), que toca algunos de los temas mencionados más arriba, como las estrategias de persuasión que aplican los influencers y el diseño de juegos de ordenador con impacto cívico, pero también otros relacionados como el internet de las cosas, los problemas afectivos derivados de la excesiva exposición a compañía mecánica, o la creación de un avatar compilando nuestras contribuciones a la red que nos garantice una cierta inmortalidad digital (Bearne, 2016). Aparte de la trama de ficción de la novela, en un apéndice se incluyen enlaces a webs y resúmenes de artículos para los lectores que quieran saber más.

«¿Es éticamente aceptable diseñar juegos o cualquier tecnología con el objetivo de crear adicción y sacar provecho?»

En conjunto, son herramientas que tenemos al alcance y que, en poco tiempo, pueden trastrocar la reputación de una persona, transformar un barrio, modificar el mercado de trabajo y las relaciones no solo laborales, sino también familiares y afectivas, o cambiar lo que se entiende por la herencia que deja una persona al morir, que ahora incluye el rastro digital. Hay que tener presente que cada contribución a la red tiene una repercusión y que los programas que aprenden de las personas, como el traductor mencionado antes, trasladan la responsabilidad de su buen o mal funcionamiento de los programadores a los usuarios. En este sentido, es reveladora la experiencia que hizo Microsoft de poner en Twitter al chatbot Tay, basado en técnicas de aprendizaje automático, y que tuvo que ser retirado en menos de 24 horas debido a sus comentarios racistas y misóginos, que había aprendido conversando con humanos en un chat (Hunt, 2016).

Robots sociales y acercamiento de los tecnólogos a las humanidades

Hace medio siglo se instalaron los primeros robots industriales en cadenas de producción del sector automovilístico para realizar tareas repetitivas o peligrosas, a menudo enjaulados por razones de seguridad y después de ser programados por personal experto. Actualmente la necesidad de mano de obra se ha desplazado de las fábricas hacia los sectores de salud y de servicios, y se están diseñando robots capaces de realizar tareas variadas en entornos humanos y de ser instruidos por personas no expertas.

Estos robots, calificados de «sociales», son producto de una serie de avances en mecánica, procesado visual y acústico, control adaptativo, computación e inteligencia artificial (Torras, 2016), que hacen posible su interacción amigable y segura con personas, un aspecto crítico y de considerable dificultad técnica, especialmente cuando esta interacción comporta contacto físico. Uno de los mayores retos actuales es proveerlos de capacidad de aprendizaje para que puedan adaptarse a usuarios diversos y entornos cambiantes, así como hacer frente a situaciones imprevistas. Los avances en esta dirección darán lugar sin duda a robots más útiles y versátiles, pero a su vez intensificarán el debate sobre si se tiene que dotar a los robots de más autonomía y capacidad para tomar decisiones, no solo en contextos críticos como el militar y el médico, sino también en los ámbitos asistencial y educativo. Como mencionábamos en la introducción, un anciano con un leve deterioro cognitivo podría creer que el robot que lo cuida se preocupa realmente por su bienestar y delegarle todas las decisiones. O un niño demasiado apegado a su compañero robótico podría no desarrollar la capacidad de empatía.

Para abordar este tipo de cuestiones, la comunidad robótica se ha acercado a las humanidades y se han puesto en marcha numerosas iniciativas en dos grandes áreas: la regulación legal y la educación ética. Por lo que respecta a la primera, instituciones como el Parlamento Europeo, el South Korean Robot Ethics Charter, la IEEE Standards Association o la Standard Institution de Gran Bretaña están elaborando normativas para los diseñadores, programadores, y usuarios de robots.

La vía de la educación ética es de amplio espectro y alcanza desde textos para estudiantes de secundaria hasta cursos en línea para el gran público, pasando por materiales para la actualización de los profesionales y, sobre todo, libros y artículos para formación universitaria. Asociaciones tan prestigiosas como el Instituto de Ingenieros Eléctricos y Electrónicos (IEEE, por sus siglas en inglés) y la Asociación de Maquinaria Computacional incluyen en sus planes de estudios para las carreras de ingeniería e informática una asignatura de ética aplicada a la tecnología, en la que cada vez más se tratan temas de ética en robótica, una materia que se ha bautizado como roboética (Lin, Abney y Bekey, 2011; Veruggio, Operto y Bekey, 2016). Los aspectos más debatidos son los que afectan a los ámbitos militar y médico, junto a los de privacidad, responsabilidad legal y fractura digital. Las cuestiones de carácter afectivo, psicológico y social, como las mencionadas más arriba, solo ahora empiezan a plantearse con el auge de la robótica asistencial.

«Una persona enferma podría creer que el robot que le cuida se preocupa realmente por su bienestar y delegarle todas las decisiones»

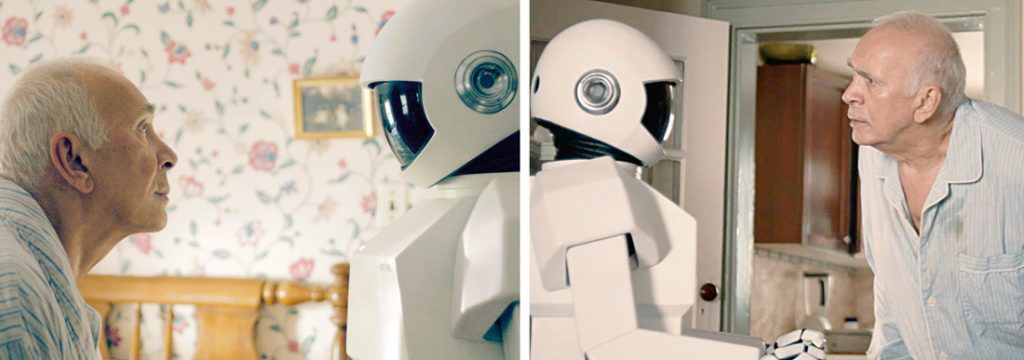

También aquí, como antes en el ámbito de internet y las redes sociales, cuando se intenta establecer un debate ético o impartir un curso, a menudo se recurre a la ciencia ficción. Algunos de los temas abordados en las obras clásicas de Asimov, Dick o Bradbury, como las tres leyes de la robótica, las niñeras mecánicas o las réplicas humanoides, han cobrado actualidad con el desarrollo de los robots sociales. También películas y series recientes permiten debatir temas de roboética y son utilizadas en cursos, tanto en línea como presenciales. Querría destacar la serie Real humans –en la que robots de apariencia casi humana conviven con las personas y a menudo entran en competencia con ellas–; la película Los sustitutos (Surrogates en su versión original) –en que cada ciudadano tiene un avatar que controla desde casa y a través del que se mueve por la ciudad y se relaciona con otras personas–, así como la novela The windup girl (traducida al español como La chica mecánica) –en la que un robot adquiere conciencia de que ha sido construido para servir a las personas y se pregunta por sus derechos y deberes–. La película Un amigo para Frank (Robot and Frank en inglés) –que muestra la relación entre un hombre mayor, Frank, y su robot cuidador– merece una mención especial por su realismo y valor pedagógico, y ha servido de base para un curso en línea del sitio web Teach with movies, entre otros.

En el contexto de la enseñanza universitario, mi novela La mutació sentimental (Torras, 2008) ha sido traducida al inglés con el título The vestigial heart (Torras, 2018) y publicada junto a unos materiales éticos para impartir un curso sobre ética en robótica social e inteligencia artificial. El objetivo es proporcionar directrices útiles para los estudiantes y profesionales (diseñadores de robots, fabricantes y programadores), así como para los usuarios finales y el público en general. Se tratan seis grandes temas: cómo diseñar el asistente «perfecto»; la importancia de la apariencia y la simulación de emociones para la aceptación de los robots; la robotización en los ámbitos laboral y educativo; el dilema entre la toma de decisiones automática y la libertad y dignidad humanas, y la responsabilidad civil relacionada con la programación de una «moral» en los robots. La elaboración de cada tema está basada en escenas de la novela, que trata de una sociedad futura en la que cada persona tiene su asistente robótico y en la que recobra la vida una adolescente de nuestra época a quien criogenizaron porque sufría una enfermedad incurable. El conflicto con los humanos futuros, que han sido criados por niñeras artificiales, han aprendido de maestros robóticos y comparten trabajo y ocio con humanoides, está servido.

Conclusión

La creciente interconectividad entre personas en las redes sociales y con todo tipo de dispositivos y robots en la vida cotidiana plantea una gran cantidad de retos –tanto de investigación tecnocientífica como de humanidades y ciencias sociales– con un elevado potencial para marcar el futuro, y que están propiciando un interesante debate social y ético.

«Los programas que aprenden de las personas trasladan la responsabilidad de su buen o mal funcionamiento de los programadores a los usuarios»

A modo de ejemplo, algunas de las cuestiones consideradas son: ¿cómo evitar que chatbots y robots sean confundidos con seres vivos y los colectivos más vulnerables depositen en ellos toda la confianza y deleguen las decisiones? ¿La excesiva exposición de los niños a compañía mecánica les dificultará desarrollar la empatía y otras capacidades afectivas? En el caso de datos médicos o de seguridad, ¿cuándo tiene que prevalecer el bien común sobre la privacidad de los datos personales? ¿Cómo compatibilizar la toma de decisiones automática con la libertad y dignidad humanas? ¿Es lícito diseñar dispositivos o programas para que creen adicción y dependencia? ¿Cómo evitar que estos sean usados para controlar a las personas? ¿Hay que limitar el poder y el alcance de manipulación de los llamados influencers? ¿Cómo paliar la fractura digital, y otras fracturas sociales que se derivan de ella?

La filosofía, la psicología y el derecho están aportando perspectiva y conocimiento previo al debate, mientras que la ciencia ficción permite especular libremente sobre posibles escenarios futuros y el papel que les tocará representar al ser humano y a la máquina en este pas à deux al que estamos irremisiblemente ligados.

REFERENCIAS

Bearne, S. (2016, 14 de septiembre). Plan your digital afterlife and rest in cyber peace. The Guardian. Consultado en https://www.theguardian.com/media-network/2016/sep/14/plan-your-digital-afterlife-rest-in-cyber-peace

Hunt, E. (2016, 24 de marzo). Tay, Microsoft’s AI chatbot, gets a crash course in racism from Twitter. The Guardian. Consultado en https://www.theguardian.com/technology/2016/mar/24/tay-microsofts-ai-chatbot-gets-a-crash-course-in-racism-from-twitter

Lin, P., Abney, K., & Bekey, G. (2011). Robot ethics: The ethical and social implications of robotics. Cambridge, MA: MIT Press.

Swain, C. (2007). Designing games to effect social change. En A. Baba (Ed.), Proceedings of the 2007 Digital Games Research Association Conference (pp. 805–809). Tokio, Japón: Digital Games Research Association.

Torras, C. (2008). La mutació sentimental. Lleida: Pagès Editors.

Torras, C. (2016). Service robots for citizens of the future. European Review, 24(1), 17–30. doi: 10.1017/S1062798715000393

Torras, C. (2017). Enxarxats. Barcelona: Males Herbes.

Torras, C. (2018). The vestigial heart. A novel of the robot age. Cambridge, MA: MIT Press.

Veruggio, G., Operto, F., & Bekey, G. A. (2016). Roboethics: Social and ethical implications of robotics. In B. Siciliano, & O. Khatib (Eds.), Handbook of robotics, 2nd edition (pp. 2135–2160). Berlín-Heidelberg: Springer.

Von Ahn, L., & Dabbish, L. (2008). Designing games with a purpose. Communications of the ACM, 51(8), 58–67. doi: 10.1145/1378704.1378719

Wu, M. (2012, 15 de septiembre). My chapter on influencers. Lithium Community. Consultado en https://community.lithium.com/t5/Science-of-Social-Blog/My-Chapter-on-Influencers/ba-p/8213